This blog post, written by Szilárd Dömötör, is the second post in a series of blog posts on transforming the Raspberry Pi into a security enhanced IoT platform. The first post explained how to build and install the default OP-TEE implementation for the Raspberry Pi 3. This one describes how you can build your own custom Linux system (with OP-TEE) using the Buildroot environment. Continue reading Using Buildroot to create custom Linux system images

OP-TEE default build and installation on the Raspberry Pi

This blog post, written by Márton Juhász, is the first in a series of blog posts on transforming the Raspberry Pi into a security enhanced IoT platform.

This blog post explains how to build and install the default OP-TEE implementation for the Raspberry Pi 3. The easiest way is to follow the steps described in the corresponding git repo of OP-TEE. However, for the sake of completeness (and because some steps may actually be a bit confusing in the original description), we provide a comprehensive description here. Continue reading OP-TEE default build and installation on the Raspberry Pi

Enhancing the Security of the Internet of Things

The Internet has grown beyond a network of laptops, PCs, and large servers: it also connects millions of small embedded devices. This new trend is called the Internet of Things, or IoT in short, and it enables many new and exciting applications. At the same time, IoT also comes with a number of risks related to information security. The lack of security, however, cannot be tolerated in certain applications of IoT, including connected vehicles and smart factories. In those applications, security failures may lead to substantial physical damage or monetary loss. Therefore, one of the biggest challenges today, which hinders the application of IoT technologies in certain application areas, is the lack of security guarantees. Continue reading Enhancing the Security of the Internet of Things

Interdependent privacy in effect: the collateral damage of third-party apps on Facebook

by Iraklis Symeonidis, COSIC, KU Leuven

and Gergely Biczók, CrySyS Lab, BME

Recent technological advancements have enabled the collection of large amounts of personal data at an ever-increasing rate. Data analytics companies such as Cambridge Analytica (CA) and Palantir can collect rich information about individuals’ everyday lives and habits from big data-silos, enabling profiling and micro-targeting of individuals such as in the case of political elections or predictive policing. As it has been reported at several major news outlets already in 2015, approximately 50 million Facebook (FB) profiles have been harvested by Aleksandr Kogan’s app, “thisisyourdigitallife”, through his company Global Science Research (GSR) in collaboration with CA. This data has been used to draw a detailed psychological profile for every person affected, which in turn enabled CA to target them with personalized political ads potentially affecting the outcome of the 2016 US presidential elections. Whether CA used similar techniques at the time of the Brexit vote, elections in Kenya and an undisclosed Eastern European country (and several other countries) is under investigation. Both Kogan and CA deny allegations and say they have complied regulations and acted in good faith.

This blog post does not take sides in this debate, rather, it provides technical insight into the data collection mechanism, namely collateral information collection, that has enabled harvesting the FB profiles of the friends of app users. In this context, the term collateral damage refers to the privacy loss these friends suffer. In a larger nexus, this issue is part of interdependent privacy when your privacy depends unavoidably on the actions of others (in this case, your friends). Continue reading Interdependent privacy in effect: the collateral damage of third-party apps on Facebook

Territorial Dispute – NSA’s perspective on APT landscape

Boldizsár Bencsáth (Boldi) will have a presentation at Kaspersky Security Analyst Summit on 09/03/2018 Friday. The presentation is based on a technical paper which describes findings about modules and information in April 2017 Shadow Brokers leak. The particular information categorizes external APT attackers and calls them SIG1 to SIG45. For more, please check the paper. Please do not forget The corresponding external sample hash list text file.

Együttműködési megállapodás a Microsec Zrt-vel

Örömmel jelentjük be, hogy a CrySyS labor együttműködési megállapodást kötött a PKI alkalmazásában és fejlesztésében úttörő szerepet betöltő Microsec Zrt-vel.

A két szervezet az elmúlt években is aktív kapcsolatot ápolt, mely keretében a Microsec anyagi és tárgyi eszközökkel támogatta laborunk kutatómunkáját, valamint a laborból indult etikus hackercsapat, a !SpamAndHex külföldi versenyeken való részvételét. Jelen megállapodással a Microsec célja a PKI-val kapcsolatos kutatás-fejlesztési és innovációs tevékenységek kiemelt támogatása, az egyetemi kapcsolatok erősítése, a kutatásokhoz első kézből információk szolgáltatása a gyakorlati problémákkal kapcsolatban. A labor számára az előnyt a tehetséggondozási programunk anyagi támogatása, valamint érdekes, az ipari gyakorlathoz kapcsolódó kutatási feladatok megfogalmazása, és a stabil ipari kapcsolat jelentik.

A PKI kutatások területén a jövőben a labor a Microsec kihelyezett kutató laboratóriumaként működik, és közös publikációk megjelentetésére törekszik.

Az aggregált adat és a GDPR

Az előző posztban megnéztük hogyan definiálja a GDPR a személyes adat fogalmát és mi számít személyes adatnak a definíció szerint.

Ebben a posztban egy mérnöki (és talán jogi) szempontból jóval izgalmasabb kérdést vizsgálunk: Személyes adatnak minősülhet-e az aggregált/statisztikai adat?

DEFCON '17 – A verseny

A Föld legelismertebb hacker versenye a DefCon konferencia Capture-the-Flag versenyének döntője, amit minden évben Las Vegas városában rendeznek, idén már 21. alkalommal. Az előző évekhez képest változás volt, hogy az eddig megszokott Bally’s helyett a Caesars Palace-ben rendezték meg a versenyt. A döntőbe jutáshoz egész évben rendeznek kvalifikációs versenyeket, és nagy örömünkre hackercsapatunk, a !SpamAndHex idén is részt vehetett a döntőben, immár harmadszorra.

A döntő egy több napos esemény, ahol a világ legjobbjai mérik össze tudásukat és stratégiájukat, idén 15 csapat. Mert ugyan nagyon fontos megtalálni és javítani a hibát, valamint a sikeres támadás pontot ér, de ez nem minden. A versenyen valóshoz közeli szituációban kell helyt állni: a csapatoknak a sérülékenység-keresés és a titkos információk megszerzése mellett IT rendszert is kell üzemeltetniük. És ha nem elérhető egy szolgáltatás, akkor a csapat pontokat veszít, mert a való életben sem örülünk, ha nem férünk hozzá a szükséges szolgáltatáshoz.

És itt jön képbe a stratégia. Ha sikeresen támadunk a versenyen és megszerezzük a titkos információt, pontot nyerünk. Ha nem elérhető egy-egy szolgáltatás, pontot veszítünk. Viszont minden csapat ugyanazokat a szolgáltatásokat üzemelteti, vagyis ha megtámadunk valakit, azzal nem csak pontot szerzünk, hanem a hibára is rávezetjük a másik csapatot. Ráadásul mutatunk nekik egy működő támadást, amit akár ellenünk is felhasználhatnak. Szóval védekezni is kell: ha megtaláltuk a sérülékenységet, nem csak ki kell használnunk mások rendszerében, hanem javítanunk is kell a sajátunkban.

Az üzemeltetési felelősség miatt a csapatok kapnak némi felkészülési időt, hogy kiismerjék a rendszert, amiért felelnek. A döntőben ez a verseny kezdete előtti nap volt. Itt találkoztunk először a cLEMENCy platformmal, ami nagyon távol áll a megszokott IT rendszerektől. Hagyományos rendszerekben a memóriában a legnagyobb helyi értékű számjegyet vagy a szám végén (big-endian), vagy a szám elején (little-endian) szokás tárolni. Ezzel szemben a cLEMENCy middle-endian, vagyis a legnagyobb helyi értékű számjegy a szám közepén helyezkedik el. Ez kihívássá teszi a memória olvasását és értelmezését, ráadásul nem léteznek kész eszközök, amik ezt kezelni tudnák. Arról nem is beszélve, hogy a cLEMENCy-n minden byte 9 bitből áll az általánosan megszokott 8 helyett. Vagyis adott egy nagyon különleges platform és egyetlen egy nap (!), hogy elkészüljenek azok a szoftverek, amelyek segítenek a platformra készült feladatok megoldásában.

Alapvetően háromféle szoftverre van szükség: assembler, wrapper és disassembler. Először az assemblert készítettünk el, hogy a saját magunk által írt programokat lefordíthassuk a cLEMENCy platform nyelvére és futtathassuk azt. A futtatáshoz egy emulatort kaptunk, vagyis nem egy fizikailag létező számítógépen futottak a feladatok, hanem egy kibertérben futtatott számítógépen. Az emulator köré készítettük el a wrappert, hogy szüneteltethessük a programok futását és futás közben megnézhessük a memória, valamint a regiszterek tartalmát. Ez sokat segített hibakeresés közben, de még mindig hiányzott a disassembler. Ugyanis a futtatható binárisok értelmezését és visszafejtését nem gépi kód szinten szoktuk végezni, hanem megpróbálunk visszalépni az ún. assembly szintre, ami ugyan sokkal kevéssé olvasható, mint egy jól ismert programozási nyelven írt forráskód, de legalább az utasításokat és operandusaikat nem számokként látjuk, hanem olvasható formában tudjuk értelmezni.

A verseny első napján a szervezők reggel 9 órakor nyitották meg a CTF termet a versenyző csapatok előtt. A csapatok 1 órát kaptak, hogy felállíthassák hálózataikat, majd 10 órakor megkezdődött a verseny.

A tavalyi megmérettetéshez hasonlóan a csapatok szolgáltatásai egy központi helyen futottak. A szolgáltatásokhoz tartozó futtatható binárisokat egy webes felületen lehetett lecserélni, azonban minden csere látható volt minden más csapat számára. Ezt az jelentette, hogy akár egy másik csapat által készített futtatható binárist is használhatott egy csapat. Ez azonban veszélyeket is rejt magában. Ha értelmezés nélkül kezdenénk el lecserélni a futtatható binárisainkat azokra, amiket a többiek készítettek, előfordulhat, hogy hátrányba kerülünk a többiekkel szemben, mert pl. nem képes futni a progam, vagy rejtett csapdát helyeztek el benne a készítők.

A legelső feladatot rubix névre keresztelték a szervezők és a Rubik-kocka megoldását implementálta. Az első dolog, ami megütötte a szemünket, az volt, hogy a program az emulátorban csak bináris adatokat jelenített meg a képernyőn. Ezért nagyon gyorsan le kellett fejlesztenünk egy kisebb szoftvert, ami a 9-bites bájtokat lefordította 8-bites bájtokra. Ezután tudtuk csak elkezdeni értelmezni a feladat kimenetét. Ezt a feladatot először a HITCON csapat oldotta meg, majd lassan a többi csapattól is elkezdtek beérkezni a megoldások.

A nap folyamán további 2 feladatot adtak ki a szervezők, amiket szinten a HITCON csapat oldott meg elsőre. Összesen 10 órán keresztül tartott ez a nap, ami elég fárasztó volt. Sikerült támadást készítenünk a rubix feladathoz és két másikhoz is. Azonban hamar rájöttünk, hogy az eszközeink nem elég hatékonyak, nem tudjuk elég gyorsan megérteni a futtatható binárisok működését. Ezért egyre nagyobb hangsúlyt helyeztünk a hálózati forgalom elemzésére is. A célunk az volt, hogy a hozzánk érkező hálózati forgalomból ki tudjuk emelni a támadásokat, amiket más csapatok indítottak ellenünk. Azonban ez csak első olvasásra ilyen egyszerű, mivel a folyamat tele volt hamis riasztásokkal a szervezők által beszúrt direkt félrevezető forgalom miatt. Ráadásul a hálózatelemző szoftvert (Wireshark) is át kellett írnunk, hogy 9-bites bájtokkal dolgozzon.

A második nap végére a 15. helyen álltunk.

A verseny utolsó napja már csak 4 órás volt. A korábbi évekhez hasonlóan a scoreboardot nem láthattuk így csak az előző este eredményeire lehetett támaszkodni. Ez a nap is egy új szolgáltatással indult babyecho néven, ami gyakorlatilag egy nagyon egyszerű format string sérülékenységet tartalmazott. A feladat érdekessége az volt, hogy a nyilvánosságra hozatalt követően 1-2 percen belül a Tea Deliverers már meg is oldotta. A verseny után a szervezőkkel beszélve Ők ennek kapcsán arra gyanítanak, hogy már előtte valahogyan meg tudták szerezni a binárist és úgy dolgoztak rajta előtte. Az persze kérdéses, hogy a verseny szabályzatával ez mennyire összeegyeztethető, de ezt most nem célunk megítélni. A lényeg, hogy ezt sérülékenységet mi is sikeresen kihasználtuk és javítottuk. A méréseink alapján az utolsó napon még 3 támadásunk sikeresen szerzett és küldött be flageket.

A verseny a szokásos módon a ‘Europe – The final countdown’ klasszikusával ért véget 2 órakor. A verseny után beszélgettünk több csapattal köztük a Shellphish-sel Santa Barbarából, a pasten-nel Izraelből vagy például az Eat, Sleep, Pwn, Repeattel Németországból.

A verseny záró eseményén a szokásokhoz híven csak az első három helyezettet sorolták fel, akik név szerint az immár negyedszerre győztes (és ezáltal a legsikeresebb csapat a DEFCON 21 éve alatt) PPP (USA), HITCON (Taiwan), A0E (Kína). Őszinte gratuláció a csapatoknak ezért a hihetetlen eredményért!

Összességében elmondható, hogy a tavalyi évhez hasonlóan nagyon sokat számított, hogy egy adott csapat milyen eszközkészlettel rendelkezett a verseny megkezdése előtt, illetve mennyire ügyesen tudta ezeket a toolokat felhasználni. Nálunk sajnos ezek nem tudtak eléggé kiforrni a verseny ideje alatt, így elég nagy hátrányban voltunk a verseny többi szereplőjéhez képest. Ettől függetlenül úgy gondoljuk, hogy ismét nagyon sok gazdag élménnyel gyarapodtunk.

Végül, de nem utolsó sorban hivatalosan is megköszönjük minden támogatónknak, hogy lehetővé tették a kiutazásunkat és ezáltal szerepelhettünk ismét ezen a világszintű megmérettetésen. A verseny tényleges eredményétől függetlenül büszkék vagyunk arra, hogy a világ 15 legjobb csapata között tudhatjuk magunkat évről évre és ezáltal nemcsak magunknak és a CrySyS Labornak, hanem talán az egész országnak is öregbítettük a hírnevét.

Defcon 2017 CTF – kezdetek

A CrySyS Lab egy olyan szervezet, ami folyamatosan fejlődik, átalakul, szervez, csinál, kitalál, megold, és úgy általában, aktív és dolgozik. Van egy hacker csapatunk, a neve !SpamAndHex. Van saját twitterük is https://twitter.com/SpamAndHex.

De mit csinál egy hacker csapat? A black hat hacker feltör rendszereket a saját előnyére, a white hat hacker biztonságosabbá teszi az Internetet, azáltal, hogy a felfedezett hibákat kezeli. A responsible disclosure az a folyamat, amikor egy hacker felfedez egy hibát, és azt nem csak úgy beleönti az Internetbe, hanem felelősségtelejesen segíti a hibát elkövető céget, hogy ki lehessen azt javítani. Az ethical hacker egy white hat hacker aki felkérésre dolgozik, általában pénzért.

A hacker csapat viszont más. A hacker csapat hacker versenyeken versenyez. Minden nagyobb biztonsági konferenciának van hacker versenye, ezeket többnyire CTF-nek (Capture The Flag) hívják, ami a hagyományos zászlófogásos harci játék megfelelője akar lenni. Itt azonban a flag többnyire egy titkos információ, ezt kell megszerezni egy szolgáltatás megtörésével, egy kriptográfiai feladat megoldásával, vagy bármi más hasonlóval. Hacker feladattal. A feladatokat más hackerek készítik, a szervezők. Nem éles rendszereket kell feltörni, hanem valóshoz hasonló megoldásokat. Például egy banki rendszerhez hasonló megoldást, melynek a biztonsági problémája hasonló egy valódi bankban potenciálisan elkövetett hibával. Vagy feladat lehet egy hangfájl analízise, amely fájlban valaki elrejtett egy titkos információt.

A hackercsapatok versenye tehát arról szól, hogy ki érti jobban a hacker technikákat, ki gyorsabb, okosabb, ügyesebb. Nem ezért, hogy majd jól feltörje a szomszéd hálózatát, hanem azért, mert ezzel a tudással jót tud tenni. Megvédeni a céget, az országot, megtalálni a hibát a hálózatban, a programban, kezelni a beeső támadásokat vagy éppen feltárni egy korábban elkövetett támadás menetét a nyomokból. Tehát megvédeni a világot.

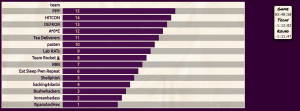

Sokféle verseny – sokféle feladvány. Nem egy konferencia van, nem egy CTF verseny, hanem tucatszámra bonyolított versenyek. Senki nem tud indulni mindegyiken. A legjobb értékmérő talán a CTFTime.org. Ők összegzik az összes hackerverseny eredményét, súlyozzák azokat és végül kibökik, abban az évben melyik csapat hogyan teljesít. Most éppen a !SpamAndHex 18. éves szinten, de voltunk már 5. helyezettek is. Ötödiknek rangsorolt csapat a Földön! Szerintünk ez nagyon durva. A 18. helyezés is olyan, hogy nagyon durván jó. És nyilván függ a helyezés a tudáson túl attól is, hogy mennyi idő marad a csapatnak egy évben több tucat versenyen részt venni. (A felkészülésre is kellene idő persze…). Egy ötödik hely olyan, hogy csak négy országot tudsz elénk képzelni, pedig nem egy informatikában fejlett ország van a világban. Találgass, ki végzett előttünk!

Szóval van egy hacker csapatunk. A Föld (világot nem írok, hátha vannak kint is) legelismertebb hacker versenye a DefCon konferencia CTFdöntője Las Vegas városában. Ez a konferencia már évekkel ezelőtt is kb. 20 000 fős volt, olyan tömegrendezvény, amit nehéz elképzelni. 1000 fő fölötti előadótermeknél nem lehet bejutni, mert telt ház van az aktuális előadásra. Olyan konferencia, ahol a sima buheráció, a hackelés, vagy éppen a cosplay is összejön. Állsz a folyosón és szembejön egy terminátornak beöltözött ember, és ezen a legkisebb mértékben lepődsz meg. Viszont az árnyoldalakról is érdemes megemlékezni: alig jutsz be előadásokra, mert későn érsz oda, az ebédre meg beállsz egy olyan gyorsétterem sorába, ahol 1 óra várakozással bírsz venni egy hamburgert. A magyar árak duplájáért.

Küldtünk hírt korábban: A !SpamAndHex bejutott a DefCon döntöjébe, ahova 15 csapat kerülhet a Földről. Nem először jutott ide be a csapat, hanem sorban a harmadik alkalommal. Ez nyilvánvalóan nem véletlen. Köszönjük a Forbes hasonlatát, egyben gratulálunk Hosszú Katinkának a friss eredményeihez, boldogság, ha sikereinket hozzá hasonlítják. Szóval most indul a döntő. Fontos látni: nem az a kérdés, hogy megnyerjük-e vagy 15. helyezést fogunk elérni. Az a lényeg, hogy ott vagyunk, harmadszorra. Az a lényeg, hogy a kimenő csapatainkat ismerik, elismerik, beszélnek velük. Az, hogy már sok helyen tudják, milyen a magyarok hacker csapata. Ebben az évben a hacker csapat már kb. 5 olyan külföldi versenyen is részt vett, ahol helyileg is meg kellett jelenni, nem csak távolról versenyezni, és ezek többségében a szervező fizette az útiköltségeket is. Körbebarangolni a világot Oroszországban, Kínába, Lengyelországan, vagy éppen most (szponzori támogatásból) Amerikában, azért az álma lehet sok diáknak. Várjuk, hogy ők is a csapatunk tagjai legyenek egyszer.

Szponzoraink:

A személyes adat és a GDPR

Ebben a posztban először áttekintjük a személyes adat fogalmát példákkal illusztrálva, ahogyan azt a 2018. május 25-én érvénybe lépő új európai adatvédelmi rendelet (GDPR) definiálja. A GDPR kötelezettségei bárkire vonatkoznak, aki európai uniós polgár személyes adatát tárolja vagy dolgozza fel (függetlenül ezek helyétől), és a kötelezettségek mulasztása jelentős anyagi és jogi következményekkel járhat. Viszont az adat személyes jellegének megítélése korántsem könnyű, amit különböző példákkal is szemléltetünk. Megmutatjuk, hogy egy Budapest nagyságú városban a tömegközlekedést használó emberek által meglátogatott állomások listája egyedi, és kevesebb mint 5 állomás ismerete elég ahhoz, hogy egy ilyen adatbázisban bárki azonosítson egy utast. Más szavakkal kizárólag az állomások listája utasonként (név, cím, stb. nélkül) jó eséllyel személyes adatnak minősül. A probléma aktualitását a közeljövőben Budapesten is bevezetésre kerülő elektronikus jegyrendszer adja, ami lehetővé teszi az utasok által meglátogatott állomások rögzítését.